本篇给出几个常见的神经网络模型和对应的一些重要论文,可能不定期补充更新。除了阅读早期论文,具体学习也可以阅读一些最新的综述文献,或者网上的其他资料以及实现代码。

一、多层感知机(Multilayer Perceptron,MLP)

是最简单的前馈神经网络,由多个全连接层组成,每个层之间都有激活函数。

文献:

[1] 1943 - Warren S. McCulloch et al. - A logical calculus of the ideas immanent in nervous activity https://link.springer.com/article/10.1007/BF02478259

[2] 1958 - Rosenblatt - The perceptron: A probabilistic model for information storage and organization in the brain https://psycnet.apa.org/doiLanding?doi=10.1037%2Fh0042519

二、卷积神经网络(Convolutional Neural Network,CNN)

主要用于图像识别和处理任务,具有卷积层、池化层和全连接层。

文献:

[1] 1998 - Lecun et al. - Gradient-based learning applied to document recognition https://ieeexplore.ieee.org/document/726791

[2] 2017 - Krizhevsky et al. - ImageNet classification with deep convolutional neural networks https://dl.acm.org/doi/10.1145/3065386

[3] 2016 - He et al. - Deep Residual Learning for Image Recognition https://ieeexplore.ieee.org/document/7780459

三、循环神经网络(Recurrent Neural Network,RNN)

适用于序列数据的处理,具有循环结构,能够捕捉序列中的时间相关性。

文献:

[1] 1982 - J. J. Hopfield - Neural networks and physical systems with emergent collective computational abilities https://www.pnas.org/doi/abs/10.1073/pnas.79.8.2554

[2] 1990 - Elman - Finding Structure in Time https://onlinelibrary.wiley.com/doi/10.1207/s15516709cog1402_1

四、长短期记忆网络(Long Short-Term Memory,LSTM)

是一种特殊类型的循环神经网络,能够更好地处理长期依赖性问题。

文献:

[1] 1997 - Sepp Hochreiter et al. - Long Short-Term Memory https://ieeexplore.ieee.org/abstract/document/6795963

五、门控循环单元(Gated Recurrent Unit,GRU)

与LSTM类似,也是一种用于处理序列数据的循环神经网络结构,但参数更少。

文献:

[1] 2014 - Cho et al. - Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation https://arxiv.org/abs/1406.1078v3

六、生成对抗网络(Generative Adversarial Network,GAN)

包括一个生成器和一个判别器,通过对抗学习的方式生成逼真的数据样本。

文献:

[1] 2014 - Goodfellow et al. - Generative Adversarial Networks https://arxiv.org/abs/1406.2661

七、注意力机制(Attention Mechanism)

在处理序列数据时,用于动态地对不同部分进行加权,以便网络能够更好地关注重要的信息。

文献:

[1] 2017 - Vaswani et al. - Attention Is All You Need https://arxiv.org/abs/1706.03762 (Transformer)

[2] 2019 - Devlin et al. - BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding https://aclanthology.org/N19-1423/ (BERT)

[3] 2018 - Radford et al. - Improving Language Understanding by Generative Pre-Training https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf (GPT-1)

[4] 2019 - Radford et al. - Language Models are Unsupervised Multitask Learners https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf (GPT-2)

[5] 2020 - Brown et al. - Language Models are Few-Shot Learners https://arxiv.org/abs/2005.14165 (GPT-3)

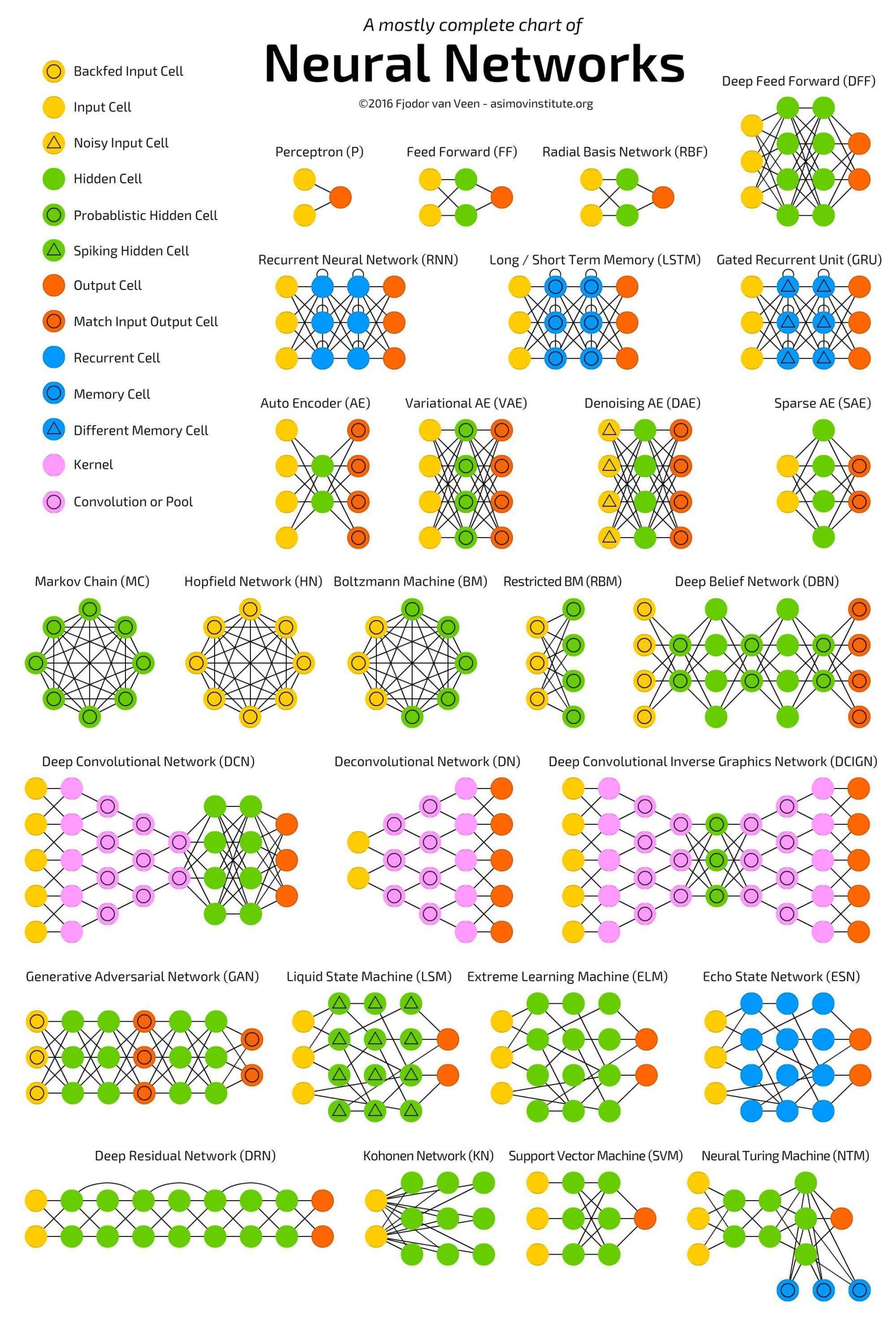

附:A mostly complete chart of Neural Networks

【说明:本站主要是个人的一些笔记和代码分享,内容可能会不定期修改。为了使全网显示的始终是最新版本,这里的文章未经同意请勿转载。引用请注明出处:https://www.guanjihuan.com】

神经网络按照结构划分有:前馈神经网络(FNN)、反馈神经网络(循环神经网络(RNN))、卷积神经网络(CNN)、自编码器(Autoencoder)。

按照层数划分:单层神经网络、多层神经网络

按照链接方式划分:全链接、局部链接

按照用途:分类神经网络、回归神经网络、强化学习神经网络

按照训练方式划分:监督学习神经网络、无监督学习(例如自编码)、强化学习神经网络

嗯,神经网络有多种分类方式,在大部分的教材中都会提到。